Сравнивать видеокарты раньше было просто. Да, конечно, были редкие исключения, вроде сжатия текстур у S3 Savage 3D и Savage4 или лучшее сглаживание у Voodoo 5.

Теперь же сравнивать видеокарты стало куда сложнее. Скажем, есть RTX 5070 Ti от Nvidia и Radeon RX 9070 XT от AMD. Карта от AMD, может быть быстрее в нативных 4K и дешевле. Но у Nvidia апскейл посредством ИИ - это DLSS4, а у AMD - FSR4. DLSS4 перешла на модель трансформера, и многие утверждают, что в 4K DLSS4 Performance по качеству изображения как нативные 4K со сглаживанием TAA.

При этом DLSS4 Performance почти в 2 раза быстрее! Это огромная разница, особенно если учесть, что любой DLSS в любой игре можно заменить на самую последнюю версию с моделью трансформера.

Некоторые скажут, мол нет, нативные 4K всё же лучше в плане качества картинки. Но тут есть 3 нюанса:

- Зависит от монитора: одно дело - 55 дюймов с метра. А другое - 4K на 27-мизерном экране с 1,2 м, когда 4K вообще неотличимы от 1440p.

- Даже если вы и увидите разницу на Ютюбе или на скриншотах, сравнивая одно с другим на одном экране, то при слепом тестировании не факт, что точно определите, где нативные 4K, а где растянутые DLSS4 с 1080p до 4K.

- Я лично сравнил DLSS4 Performance с 4K Native на 48-дюймовом OLED-мониторе с метра. Натив оказался ХУЖЕ, чем DLSS4 Performance.

Вот простые примеры - Silent Hill 2 Remake:

Native 4K

DLSS4 Performance

Native 4K vs DLSS4 Performance:

Есть, конечно, моменты, когда нативные 4K были лучше, но разница была мизерной и неочевидной и чаще был лучше именно DLSS. При этом уже DLSS4 Quality лучше натива фактически всегда и он гораздо быстрее.

Натив идеален? Или история лесенок

Многие воспринимают натив как идеал, а AI-апскейлы - как компромисс. На самом деле, как только игры стали переходить от 2D-спрайтов к 3D-полигонам, сразу возникло несколько серьёзных проблем - текстуры все в квадратах и ЛЕСЕНКИ на всех объектах на экране. Это происходит из-за квадратной формы пикселей, что усугубляет сама форма полигонов (треугольные или квадратные в случае с Sega Saturn (на этой консоли ситуация была ещё хуже)).

И если проблему с текстурами решили текстурной фильтрацией (что потребовало смены железа - что на ПК, что на консолях), то с лесенками всё было куда сложнее.

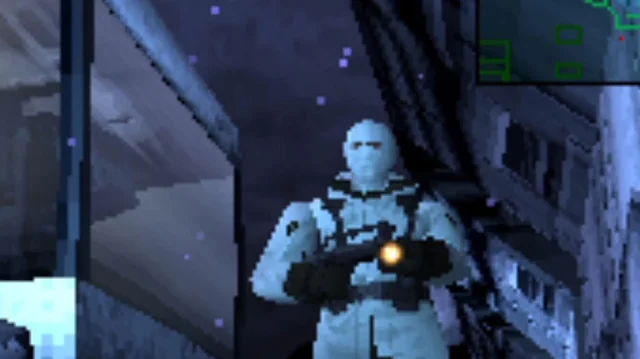

MGS1, PlayStation 1

Абсолютно все объекты в 3D-графике изгажены лесенками, и в движении они выглядят ещё хуже, чем в статике. Считайте, что в нативном разрешении артефакты в виде лесенок присутствуют на ВСЕХ объектах.

На ПК это не было такой большой проблемой из-за того, что играли в основном на 15–17-дюймовых мониторах: эти мониторы были ЭЛТ, которые из-за особенностей вывода картинки сглаживали лесенки. На консолях с ТВ проблема была серьёзнее, но и тут помогала мелкая диагональ ТВ (в 1996 она была в среднем 20–21 дюйм) от которого сидели в 2–3 метрах. Но в упор там был полный трындец (учитывая, что многие игры шли в 240p).

Mario 64 с анти-алиасингом (картинка замылена):

Mario 64 без анти-алиасинга (четче картинка):

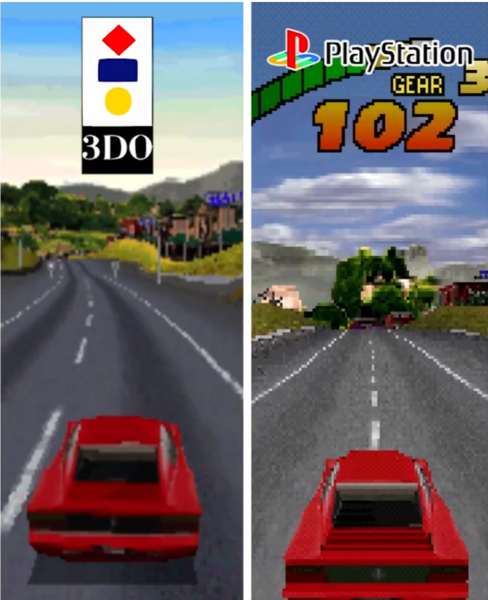

И даже тогда с лесенками старались бороться. На консолях это был софтовый антиалиасинг краёв у Nintendo 64 (см фотки экрана с Марио 64 вверху), за который приходилось платить сильным замыливанием картинки. У 3DO от Panasonic тоже был механизм, который помогал бороться с лесенками: работал он путём замыливания. Но это не было полноценным сглаживанием краёв. Тем не менее The Need for Speed на 3DO был более гладким, чем на PS1, у которой даже такого механизма не было (и некоторым, нравилось больше именно более чёткая картинка PSX, пускай и с лесенками).

На ПК, реализовать антиалиасинг стали пытаться с выходом Riva TNT, но метод был FSAA, это общий термин, по-сути там был SSAA, который рендерил в 2–4 раза более высоком разрешении, что делало игры неиграбельными на том железе. Потом пришли Voodoo 5 с весьма качественным АА и GeForce 2 с тем же SSAA, с которым игра = слайд-шоу, и жутко мыльным Quincunx AA (его даже умудрились добавить на PS3 к мыльному горю геймеров).

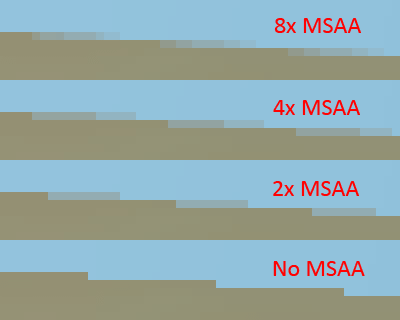

Потом пришёл GeForce 3 с MSAA, и дела уже пошли лучше.

Также MSAA использовался у GameCube и Xbox. Но проблема тут была в том, что MSAA 2x не убирал лесенки полностью и всё равно снижал производительность. А Dreamcast работал с SSAA и, ввиду падения скорости, мало где его использовал. На PS2 же извращались с софтовым АА как на Nintendo 64.

Пример хорошего софтового антиалиасинга на PS2:

А потом был переход к HD, и мелкие ЭЛТ-экраны стали заменять огромными ЖК и плазмой, на которых лесенки были гораздо заметнее. MSAA справлялся с трудом (2x не хватало, а 4–8x слишком дорого), с развитием графики MSAA стал бесполезным для некоторых объектов (сейчас он не сгладит большинство сцены). Стали появляться всякие FXAA и MLAA со своими проблемами и артефактами. Затем был SMAA (смесь MLAA и FXAA). Все они мылили картинку или артефачили, но были всё равно лучше чем играть с убогими лесенками.

Потом рендеринг игр стал настолько сложным, что пришлось использовать современный тип сглаживания TAA (Temporal AA). Т.к. никто не будет сегодня играть без АА: когда мы говорим про натив, то подразумеваем натив + TAA.

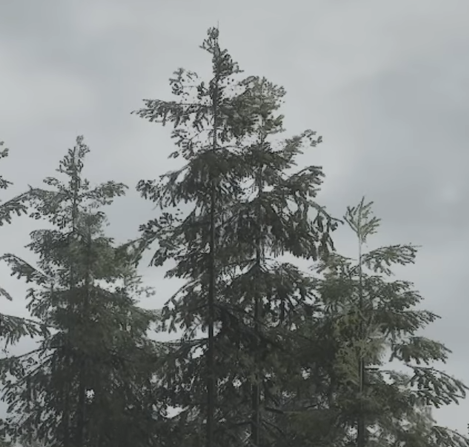

Так вот - TAA хоть и современный тип сглаживания, но он всё равно имеет проблемы: мыло в движении, гостинг, артефакты на мелких деталях и прозрачностях.

В результате у вас по сути 2 выбора - играть с артефактами в виде лесенок или играть с мылом и артефактами от TAA.

И вот тут и приходит на помощь ИИ-апскейл вроде DLSS. Нейросеть обучают в 16K (это в 16 раз выше 4K), и она убирает типичные артефакты от АА, вроде шлейфов и прочие недостатки. В итоге мы получаем практически идеальное сглаживание всей картинки без гостинга, мыла и с отличной работой даже с самыми мелкими деталями. По сути, DLSS - это рендеринг нового поколения, нейронный. Есть ещё DLAA - это ИИ-сглаживание для нативного разрешения: фактически это первый идеальный АА для нативного разрешения.

Тут вы можете глянуть, насколько лучше сглаживает даже старый DLSS2 на фоне нативных 4K с TAA: Atomic Heart - DLSSQuality превосходит нативные 4K

AI Апскейл стал обязательным для сравнения видеокарт

Что же получается? Сравнивать в разрешении без ИИ-апскейла уже нет никакого смысла. Включаем на RTX 5070 Ti DLSS4 Performance и получаем качество картинки не хуже (а может даже и лучше), чем у RX 9070 XT в нативных 4K, только с почти двухкратным преимуществом в скорости.

Но ведь и у AMD есть свой апскейл — FSR4, который можно так же включить во многих играх, хоть и работает это не так идеально, как с DLSS4. Но DLSS4 трансформер явно и очевидно лучше (и быстрее), чем FSR4, смотрите сами:

слева FSR4 Performance, справа DLSS4 Performance

И вот как их сравнивать? На картах от Nvidia можно включить DLSS4 Performance и получить качество картинки как в 4K-нативе или лучше, а вот FSR4 Performance до натива уже не дотягивает, особенно в движении (стабильность картинки у FSR4 чуть хуже, чем у DLSS3, до DLSS4 там ещё далеко). При этом, в целом, FSR4 Performance превосходит прошлый DLSS3 Performance, а FSR4 Quality лучше нативных 4K.`

В итоге логично сравнивать DLSS4 Производительность с FSR4 Баланс. Первый вариант будет примерно на 20% быстрее. Думаю что из этого и стоит исходить, если важно количество кадров в секунду и не хочется сильно терять в качестве картинки. А если количество FPS менее важно, то просто включается DLSS4 Качество — картинка при этом лучше, чем у AMD в любом режиме, и на 40% быстрее нативных 4K.

Т.е натив со своим всратым TAA - это уже прошлый век для игровых неандертальцев.

Генерация кадров, фейковых

Казалось бы, что мы всё прояснили и теперь всё ясно. Но ведь ещё есть и генерация кадров. Она есть и у Nvidia, и у AMD.

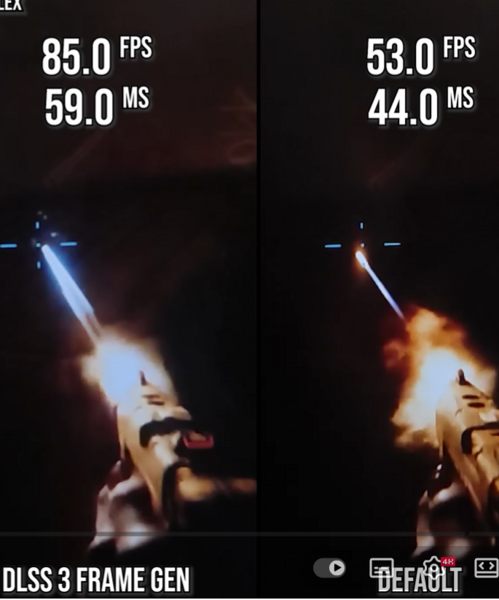

У Nvidia она в целом быстрее и точнее. Поддержка лучше. И если карта RTX 50xx, то есть ещё и мультигенерация (MFG), правда не везде. Несмотря на красивые цифры фреймрейта, MFG 4x далеко не всегда так хороша, и реальный лаг выше, чем с обычной двухкратной генерацией кадров и тем более без фреймгена вообще. Даже если счётчик FPS показывает просто гигантскую прибавку кадров, толку от них мало, если реальный лаг выше - даже по сравнению с нативом:

Вот прекрасный пример: MFG 4x — 171 FPS, а лаг существенно выше, чем без всякой генерации при 58 FPS. 69 мс против 50 мс — это важнее, чем счётчик фейковых кадров. Что же увидит игрок, играя со 171 FPS и 69 мс и с 58 FPS и 50 мс? Первый вариант будет визуально плавнее, но управление будет хуже (менее отзывчивое, с 38% задержкой). Т.е. целиться и стрелять (да и в целом всё, где нужна быстрая реакция) будет лучше без генерации кадров, несмотря на трёхкратно более низкий фреймрейт. У Nvidia, конечно, есть технология Reflex для снижения лага, и она помогает генерации кадров, но ведь нативу она тоже помогает.

Именно высокий лаг снижает полезность от генерации кадров, потому что за визуальную плавность приходится платить возросшей задержкой управления. В некоторых жанрах это критично, в некоторых нет (в таких, как правило, и от большего количества кадров толку мало).

И вот ещё один важный момент — для нормальной генерации кадров нужен базовый FPS от 40. 40 — это нормальный минимум. Именно минимум. Лучше 50–60 FPS, а ещё лучше — от 80 FPS. Для MFG 4x лучше уже от 70 до 90 FPS.

лохотрон от Нвидии

Не верьте рекламным графикам от Nvidia, где они сравнивают натив в 27 FPS и MFG 4x 238 FPS. Из 27 базовых кадров эти 238 FPS будут выглядеть как полнейшее говно с артефактами и скотским лагом.

Поэтому если вы думаете, что генерация кадров вам поможет в игре, которая без неё идёт в 30 FPS, - то вы сильно заблуждаетесь: будет только ХУЖЕ.

Ориентируйтесь на от 50 FPS. По сути, FG больше всего полезен для владельцев мониторов от 120 Гц, когда 60 превращаются в 120 FPS и лаг уже терпим (но всё ещё хуже натива).

Выводы

Апскейл и генерация кадров реально влияют на выбор видеокарты, и в целом лучше просто брать решения от Nvidia. Там лучше и апскейл, и генерация. Если хотите сравнить GeForce и Radeon, то ориентируйтесь на DLSS4 Performance vs FSR4 Balance и решайте, стоит ли это 100–150$ экономии и переплаты. Если же для вас главное - качество картинки, то ваш выбор - DLSS4 Quality в 5K (через DSR (Dynamic Super Resolution) - опцию в драйвере Nvidia).

В целом революция ИИ уже внесла непонятки в то, как именно сравнивать GPU от разных производителей - у каждого свой апскейл и своя генерация кадров. И если на ПК до недавнего времени всё было просто - сравнивайте DLSS3 с FSR3 в режиме качества, - то переход DLSS на модель трансформера сделал привлекательным даже режим Производительность, на который раньше многие бы даже не посмотрели.

С выходом новой архитектуры от AMD RDNA5 - всё станет ещё сложнее. У FSR4 (гибрид между CNN и трансформер моделями) режим Производительности тоже стал значительно лучше, чем у FSR3.

Консоли тоже идут по пути AI-апскейла. У PS5 Pro своя технология на базе FSR — PSSR, а у Switch 2 уже DLSS (не трансформер). Консольные технологии апскейла уступают последним версиям на ПК (PSSR не дотягивает даже до FSR4 Performance, но в 2026 Sony обещает выпустить апгрейд на основе технологий FSR4), но в следующем поколении, думаю, что AI-апскейл будет во всех играх и в нормальном качестве. Будем, как обычно, играть на Playstation 6 в 720p растянутых AI до 4-8K.

Надеюсь, что в данной статье я немного прояснил ситуацию со сравнением GPU в современных ИИ-условиях.